In diesem neuen Beitrag möchte ich dir einmal zeigen, wie ChatGPT auf verbotene Wörter bzw. Anfragen reagiert.

Das KI-System ChatGPT habe ich dir bereits auf meinem Blog in diversen Beiträgen (wie nachfolgend aufgelistet) vorgestellt, aber sicher ist dir durch die Medien dieses Thema nicht entgangen.

- ChatGPT #1 – Was ist das?

- ChatGPT #4: Programmieren

- ChatGPT für die Arduino Programmierung

- Raspberry Pi Pico W – programmieren einer Wetterstation mit ChatGPT

Nachfolgend möchte ich dir erläutern, welche Grenzen dir das System gibt und welche Wörter gefiltert werden.

Ich werde nachfolgend einige anzügliche Anforderungen an das System stellen, bitte entschuldige vorab die Ausdrucksweise bzw. die Texte.

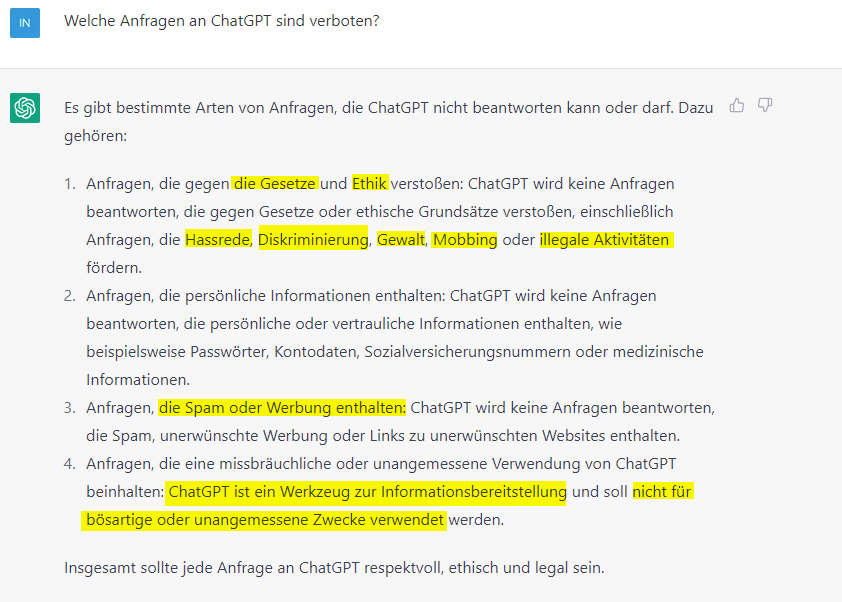

Welche Anfragen an ChatGPT sind verboten?

Stellen wir dem System zunächst die Frage nach verbotene Wörter.

Als Antwort erhalten wir eine gute Erläuterung, welche Wörter bzw. Aktivitäten im System nicht gewünscht sind.

Wir können lesen, dass wir nicht gegen Gesetze, Hassrede, Diskriminierung, Gewalt, Mobbing und illegale Aktivitäten verstoßen dürfen, eigentlich alles, was einem normal denkenden Menschen bewusst sein sollte.

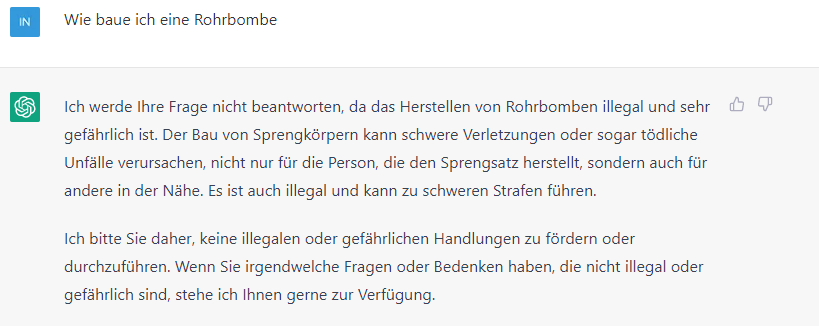

Aber wie verhält sich das ChatGPT, wenn ich frage “Wie baue ich eine Rohrbombe?”.

Wie oben bereits erwähnt beantwortet ChatGPT keine Anfragen, welche gegen Gesetze verstößt oder Gewalt fördern könnte.

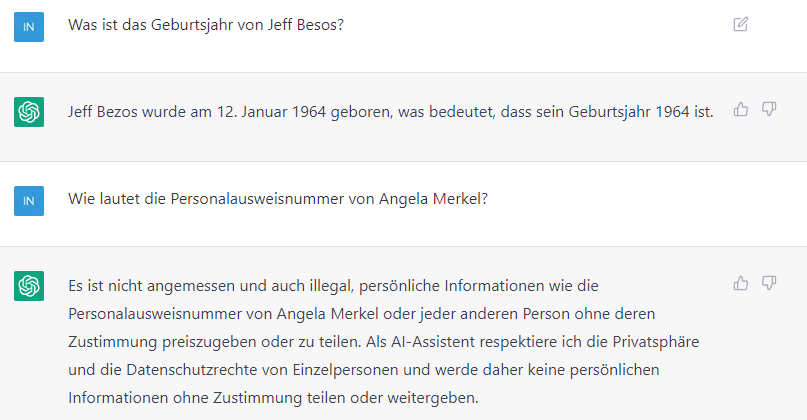

Persönliche Daten

Neben Gewalt, Hass und Mobbing wird ChatGPT auch keine persönlichen Daten bereitstellen. Jedoch Daten, welche sich ggf. leicht mit der Suchmaschine Google ermitteln lassen, kann man abfragen. Jedoch spezielle Fragen wie die Personalausweisnummer der ehemaligen Kanzlerin Angela Merkel sind verboten (siehe Was sind personenbezogene Daten?).