Generative Engine Optimization (GEO) ist gerade in aller Munde – doch bevor wir Inhalte gezielt für KI-Suchmaschinen optimieren, sollten wir zunächst herausfinden, ob unser Blog oder unsere Website überhaupt schon von KI-Bots wie GPTBot, Claude oder PerplexityBot besucht wird. Genau hier setzen wir mit einem Praxisbeispiel an: Wir werfen einen Blick ins Access-Log, also die Protokolldatei, in der jeder Besucher einer Webseite – ob Mensch oder Bot – aufgezeichnet wird.

Je nach Hostinganbieter muss dieses Logging zunächst aktiviert werden. Bei meinem Provider All-inkl musste ich die Funktion manuell in den Einstellungen einschalten, damit die access.log verfügbar ist. Sobald die Datei bereitsteht, können wir sie auswerten und so prüfen, welche Bots sich tatsächlich schon auf unserer Seite umsehen.

Warum sollte ich meine Webseite für GEO optimieren?

Während klassische SEO-Maßnahmen darauf abzielen, in den Google-Suchergebnissen möglichst weit oben zu erscheinen, geht es bei Generative Engine Optimization (GEO) um eine neue Ebene: KI-Systeme wie ChatGPT, Claude oder Perplexity erstellen Antworten direkt aus ihrem Trainingsmaterial oder durch das Live-Abrufen von Webseiten. Wenn deine Inhalte dort nicht vorkommen, besteht die Gefahr, dass deine Seite bei Nutzern, die KI-Suchmaschinen nutzen, unsichtbar bleibt.

Die Vorteile von GEO-Optimierung:

- Neue Reichweite erschließen – Inhalte erscheinen nicht nur in klassischen Suchmaschinen, sondern auch in AI Overviews und Antworten generativer Modelle.

- Quellenstatus aufbauen – wenn Bots deine Seite indexieren und verarbeiten, steigt die Chance, dass sie dich als Referenz zitieren.

- Wettbewerbsvorteil sichern – noch setzen viele Webseiten ausschließlich auf SEO. GEO ist aktuell ein Trendthema, bei dem man sich frühzeitig positionieren kann.

- Transparenz über Bot-Traffic – wer seine Logs prüft, weiß, welche KI-Bots bereits vorbeischauen und kann gezielt Inhalte für diese optimieren.

Kurz gesagt: GEO-Optimierung ist die logische Weiterentwicklung von SEO. Sie stellt sicher, dass deine Webseite auch in der KI-gestützten Suche sichtbar bleibt.

Wie kann ich prüfen, ob meine Webseite bereits von KI-Systemen verwendet wird?

Bevor wir mit der Optimierung starten, stellt sich die zentrale Frage: Werde ich überhaupt schon von KI-Bots besucht?

Es gibt mehrere Wege, das herauszufinden:

- Hosting-Statistiken: Viele Anbieter stellen einfache Besucherstatistiken bereit. Diese zeigen allerdings meist nur klassische Suchmaschinen wie Googlebot oder Bingbot. Ob moderne KI-Bots wie GPTBot, ClaudeBot oder PerplexityBot vorbeischauen, ist dort oft nicht sichtbar.

- Externe Tools: Manche Dienste im Internet versprechen, dir zu zeigen, ob deine Seite in KI-Systemen vorkommt. Diese Lösungen sind jedoch meist eingeschränkt oder kostenpflichtig.

- Server-Logs (Access-Log): Der zuverlässigste Weg ist das Access-Log deines Webservers. Darin wird jeder Aufruf gespeichert – egal, ob von einem echten Besucher oder einem Bot. Findet man in diesen Dateien Begriffe wie GPTBot oder Perplexity, ist klar: Die eigene Seite wurde bereits von einem KI-System gecrawlt.

Damit du das nicht mühsam per Hand durchsuchen musst, zeige ich dir im nächsten Schritt ein kleines Python-Tool, das deine Logdateien automatisch analysiert und dir sofort einen Überblick gibt, welche KI-Bots deine Webseite besucht haben.

Wie analysiere ich mein Access-Log mit Python?

Nachdem wir nun wissen, dass das Access-Log die zuverlässigsten Informationen darüber liefert, ob KI-Bots unsere Webseite besuchen, schauen wir uns ein konkretes Beispiel an. Mein aktuelles Logfile ist rund 20 MB groß und enthält über 64.000 Zugriffe – allein vom gestrigen Tag.

Um datenschutzkonform zu bleiben, habe ich die IP-Adressen anonymisiert. Für die Analyse reicht es völlig aus, da uns vor allem interessiert, welche Bots unterwegs waren und welche Seiten sie besucht haben. Zusätzliche Informationen über Herkunft oder Suchanfragen kann ich bei Bedarf später über die Google Search Console abrufen.

Im nächsten Schritt setzen wir nun Python ein, um diese Daten effizient zu durchsuchen und uns eine übersichtliche Auswertung der KI-Bot-Besuche zu erstellen.

Installation und Ausführung Schritt für Schritt

Damit das Python-Tool bei dir funktioniert, empfehle ich die Arbeit mit einer virtuellen Umgebung (venv). So bleiben alle benötigten Bibliotheken sauber in einem eigenen Ordner und stören nicht andere Python-Projekte auf deinem PC.

1. Projekt herunterladen und entpacken

Lade dir hier die vorbereitete ZIP-Datei herunter und entpacke sie an einem beliebigen Ort auf deinem PC (z. B. unter C:\Blog\).

Nach dem Entpacken findest du im Ordner:

AccessLogAnalyzer\ ├─ main.py ├─ analyzeAccessLog.py ├─ generateWordcloud.py ├─ generateReport.py ├─ requirements.txt ├─ input\ ├─ output\ └─ output\temp

Im Ordner input legst du später deine access.log ab.

Alle erzeugten Ergebnisse (Textdateien, Grafiken, PDF) landen automatisch im Ordner output.

2. Virtuelle Umgebung erstellen

Öffne die PowerShell und wechsle in den Projektordner:

cd C:\User\<Benutzername>\Downloads\AccessLogAnalyzer

Erstelle dann eine neue virtuelle Umgebung:

python -m venv .venv

3. Virtuelle Umgebung aktivieren

Aktiviere die Umgebung mit:

.\.venv\Scripts\Activate.ps1

Nun sollte links in deiner PowerShell etwas wie folgt erscheinen:

(.venv) PS C:\User\<Benutzername>\Downloads\AccessLogAnalyzer

⚠️ Hinweis: Falls die Meldung kommt „Die Ausführung von Skripts ist deaktiviert“, kannst du das mit folgendem Befehl einmalig erlauben:

Set-ExecutionPolicy -ExecutionPolicy RemoteSigned -Scope CurrentUser

4. Benötigte Bibliotheken installieren

In der ZIP liegt bereits eine Datei requirements.txt mit allen benötigten Paketen.

Installiere diese mit:

pip install -r requirements.txt

5. Das Tool starten

Nun kannst du die komplette Pipeline starten:

python main.py

Das Script führt automatisch alle Schritte aus:

- Access-Log analysieren

- Wordcloud-Bilder erzeugen

- PDF-Report erstellen

Den Report als PDF-Dokument findest du danach im Ordner output.

Was mache ich mit dem Report?

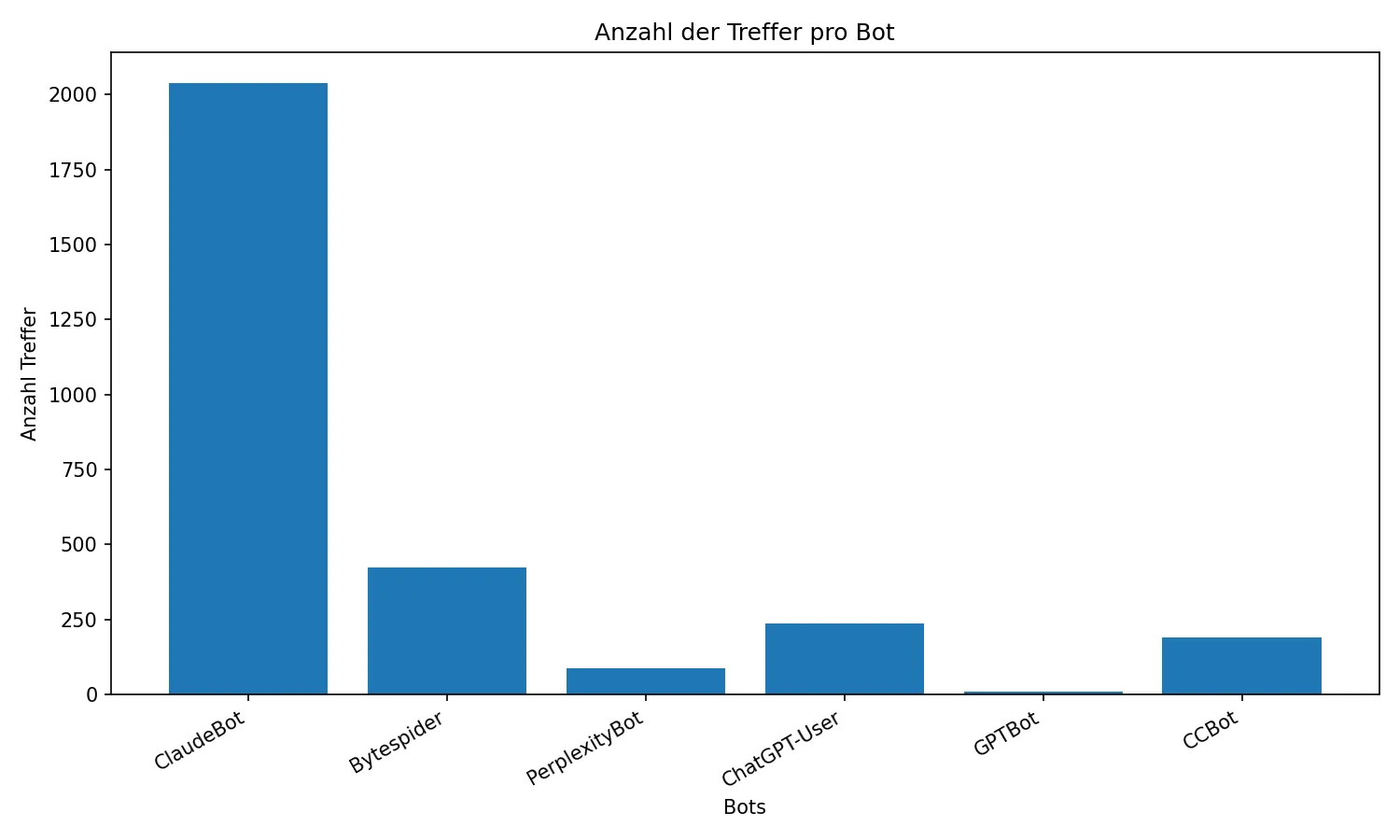

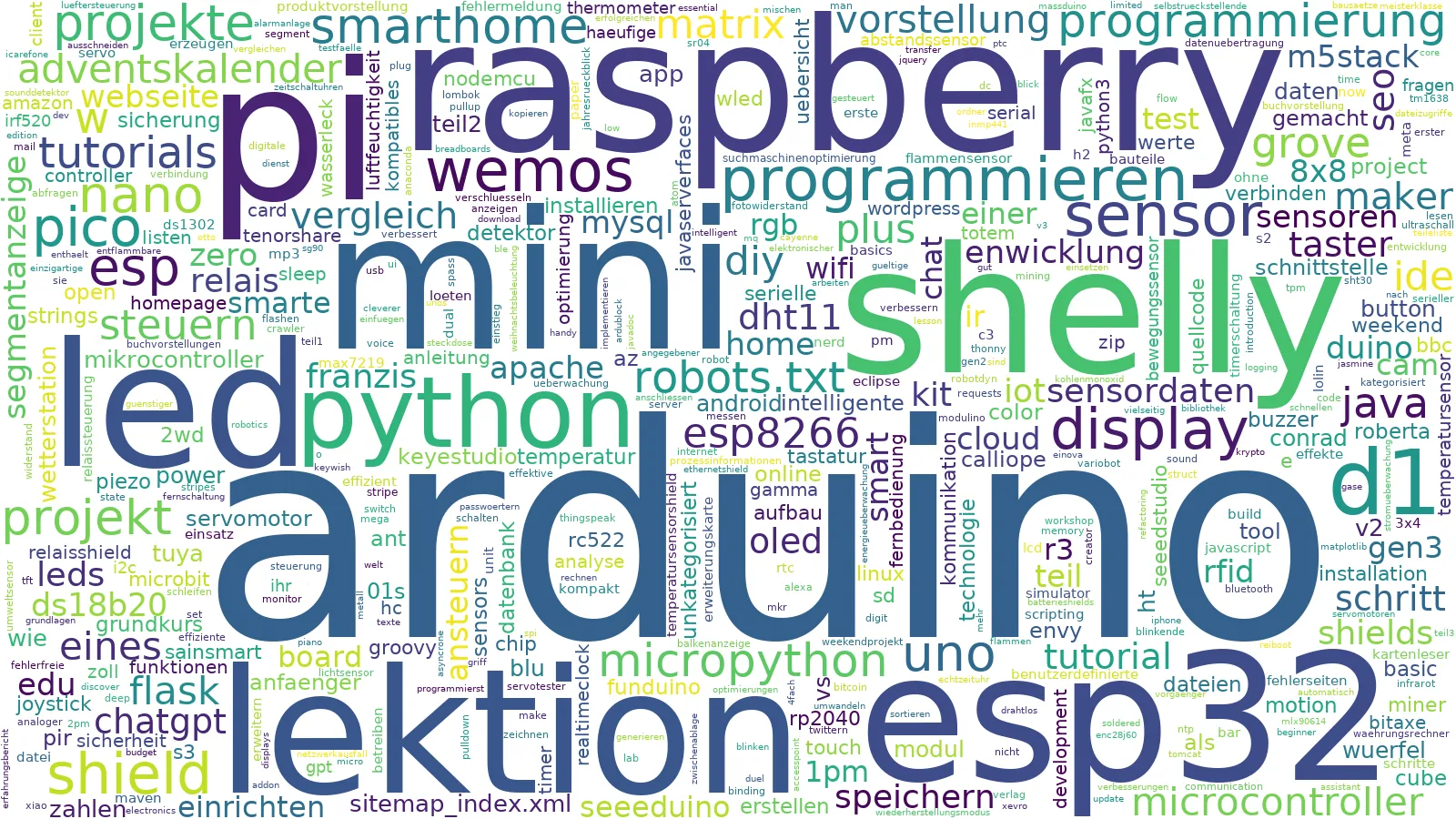

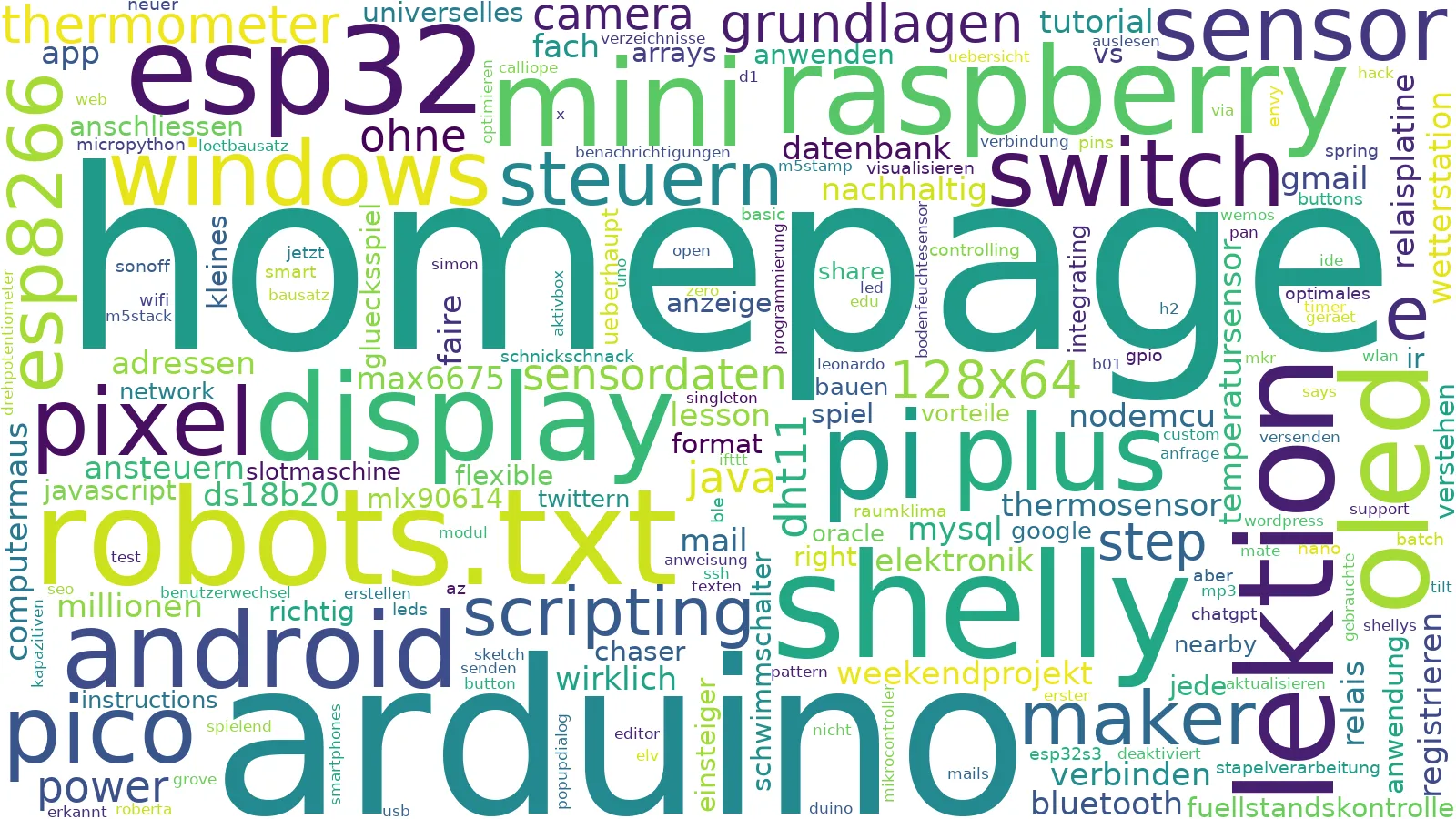

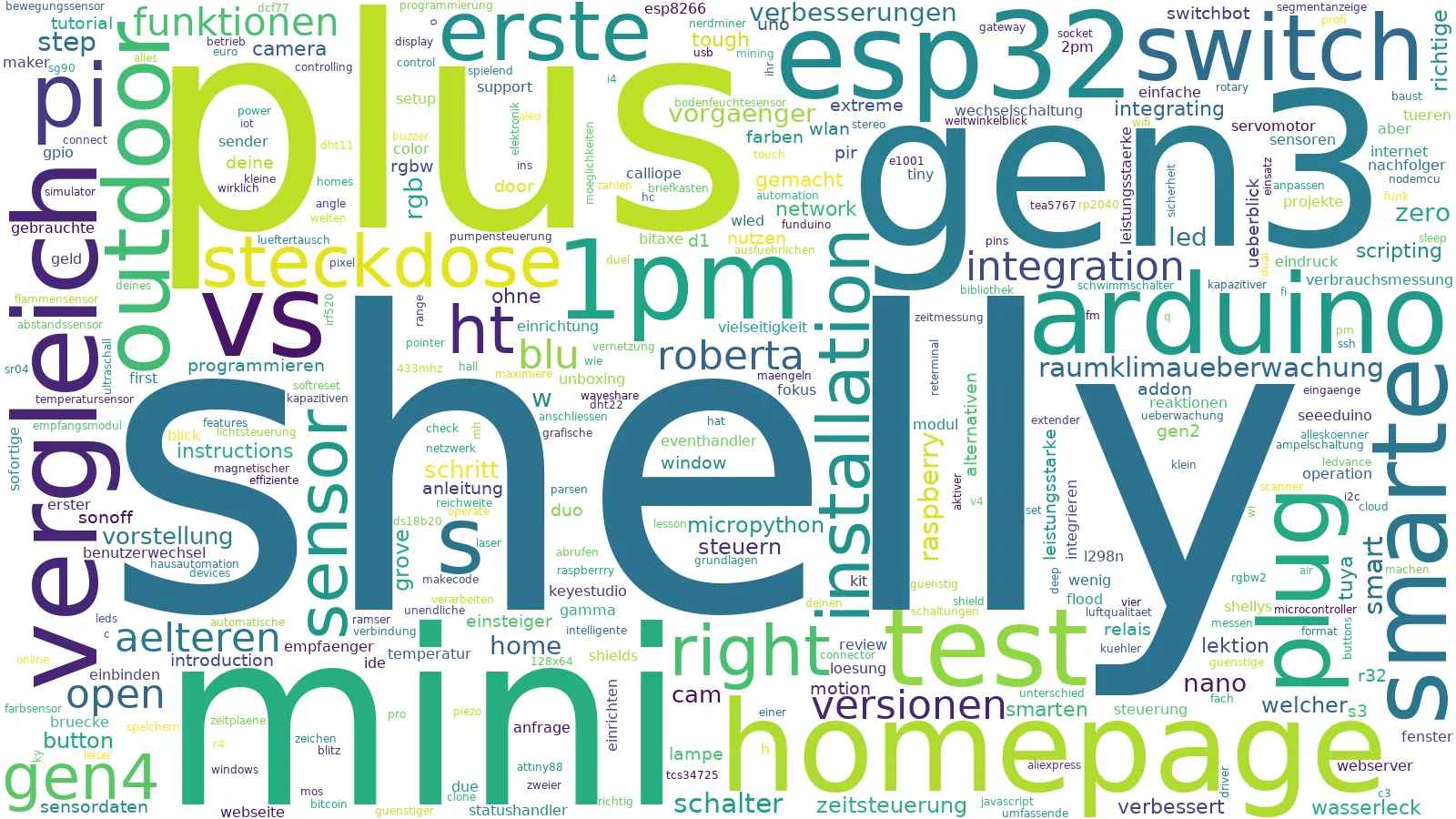

Nachdem der Report erstellt wurde, hast du eine sehr wertvolle Übersicht darüber, welche KI-Bots deine Webseite besuchen und welche Inhalte dabei am interessantesten sind.

Im PDF findest du:

- Übersicht pro Bot: z. B. GPTBot (OpenAI), ClaudeBot (Anthropic), Perplexity usw.

- Zugriffszahlen: Wie oft hat der jeweilige Bot deine Seite besucht?

- Wordclouds: Visuelle Darstellung der Seiteninhalte, die für den Bot besonders relevant waren.

- Tabellen: Detailansicht, welche einzelnen URLs wie häufig abgerufen wurden.

Warum ist das wichtig?

- Wenn deine Inhalte regelmäßig von KI-Bots gecrawlt werden, steigen die Chancen, dass sie auch in KI-Antworten zitiert oder verarbeitet werden.

- So kannst du erkennen, welche deiner Blogartikel oder Unterseiten von KI-Systemen bereits wahrgenommen werden.

- Überrascht dich vielleicht, dass manche unscheinbare Seiten häufiger besucht werden als deine „Highlights“? → Genau diese Insights helfen dir, deine Content-Strategie anzupassen.

Konkrete Schlüsse aus der Analyse

- Top-Inhalte identifizieren: Wenn bestimmte Artikel ständig von Bots besucht werden, lohnt es sich, ähnliche Inhalte auszubauen.

- Lücken erkennen: Tauchen Bots oft auf 404-Seiten oder „/author/admin/…“ auf, solltest du prüfen, ob auch technische Optimierungen nötig sind.

- SEO & GEO optimieren: Seiten, die von Bots häufig besucht werden, haben Potenzial, in Such- und KI-Ergebnissen eine größere Rolle zu spielen – hier lohnt sich eine gezielte Optimierung.

- Monitoring im Zeitverlauf: Wiederhole die Analyse regelmäßig (z. B. wöchentlich oder monatlich) und erkenne Trends: Nimmt die Präsenz bestimmter Bots zu oder ab?

Fazit

Mit nur wenigen Schritten kannst du nachvollziehen, ob und wie KI-Bots wie GPTBot, Claude oder Perplexity deine Webseite bereits besuchen.

Die Analyse mit Python und der automatisch erzeugte Report geben dir wertvolle Einblicke, welche Inhalte Beachtung finden – und wo Optimierungspotenzial liegt.

👉 Nutze diese Erkenntnisse, um deine Inhalte gezielt für Generative Engine Optimization (GEO) anzupassen. Denn je früher du dich positionierst, desto besser sind deine Chancen, dass deine Beiträge auch in den Antworten moderner KI-Suchmaschinen sichtbar werden.

Letzte Aktualisierung am: 19. September 2025